Una nuova ricerca firmata Apple mostra che è possibile addestrare un modello a riconoscere relazioni temporali nei segnali EEG senza annotazioni umane. Se metodi di questo tipo venissero impiegati in sensori auricolari, potremmo vedere AirPods capaci di supportare funzioni legate al sonno, all’attività cerebrale e a possibili anomalie neurologiche.

Che cos’è PARS e perché è importante

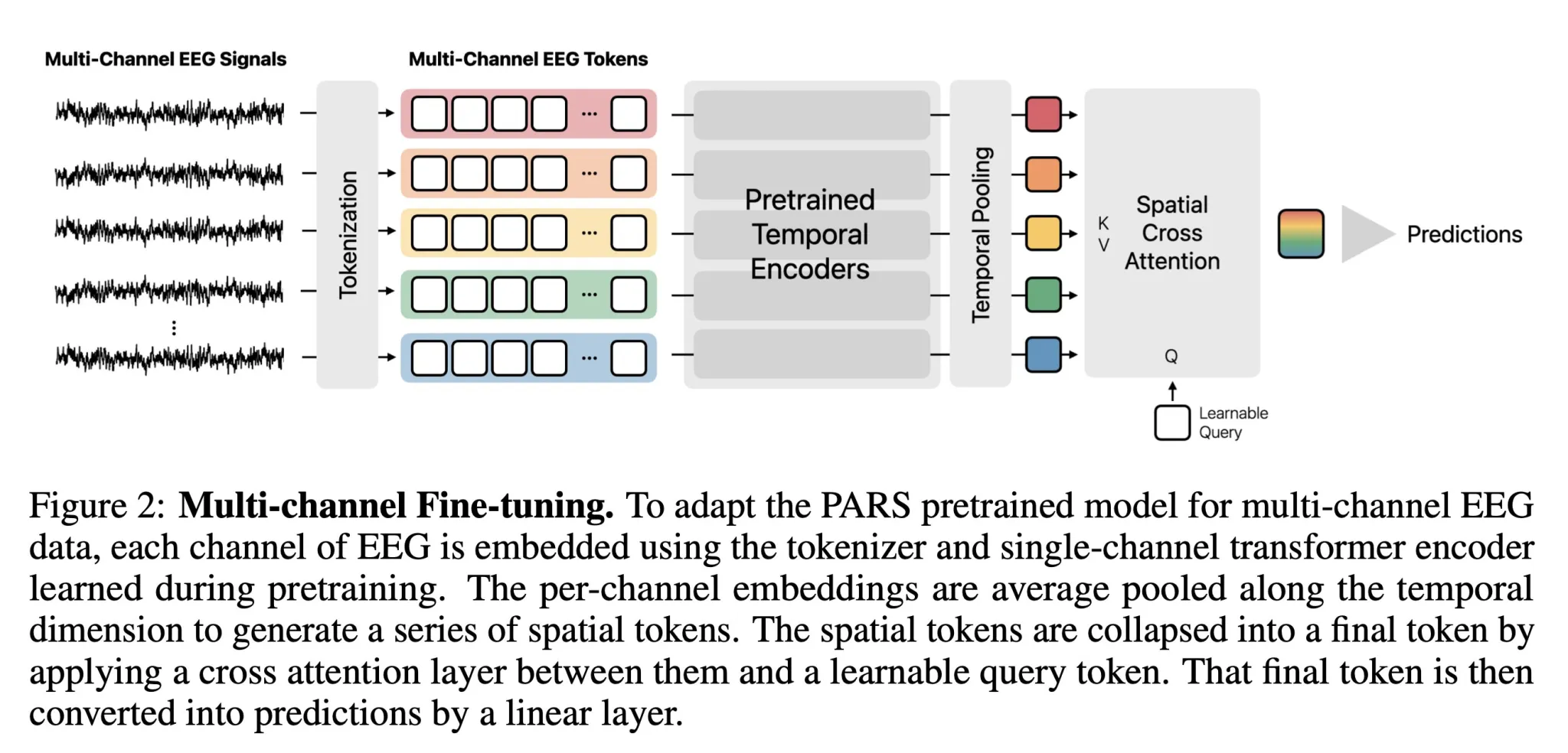

Nello studio “Learning the relative composition of EEG signals using pairwise relative shift pretraining”, i ricercatori Apple introducono PARS, acronimo di PAirwise Relative Shift. L’obiettivo è superare un limite noto: i modelli attuali si basano su dataset in cui esperti hanno segnato manualmente le fasi del sonno, l’inizio di una crisi epilettica o eventuali anomalie.

PARS fa il contrario. Si allena da solo prevedendo quanto distanti nel tempo siano due porzioni di segnale EEG pescate a caso. È un approccio di self-supervised learning, pensato per catturare non solo i pattern puntuali ma anche le relazioni temporali più ampie.

Nel paper troviamo spiegato che questo tipo di pretraining permette ai modelli di cogliere dipendenze a lungo raggio nei segnali neurali. E in effetti, dai test su quattro benchmark diversi, il modello pre-addestrato con PARS ha superato o eguagliato i metodi precedenti in tre casi su quattro.

Dai dataset al possibile ruolo degli AirPods

I ricercatori hanno utilizzato quattro dataset:

- Wearable Sleep Staging (EESM17)

- Abnormal EEG Detection (TUAB)

- Seizure Detection (TUSZ)

- Motor Imagery (PhysioNet-MI)

Il dataset più interessante per noi è EESM17, che contiene registrazioni notturne raccolte con un sistema ear-EEG indossabile, cioè un dispositivo capace di registrare l’attività cerebrale direttamente dall’orecchio.

Dal canto suo, l’ear-EEG non è identico al classico EEG sullo scalpo, ma riesce comunque a rilevare segnali clinicamente rilevanti come le fasi del sonno o alcuni pattern associati alle crisi epilettiche. E il fatto che Apple utilizzi proprio questo dataset lascia intendere che l’azienda stia esplorando seriamente questa strada.

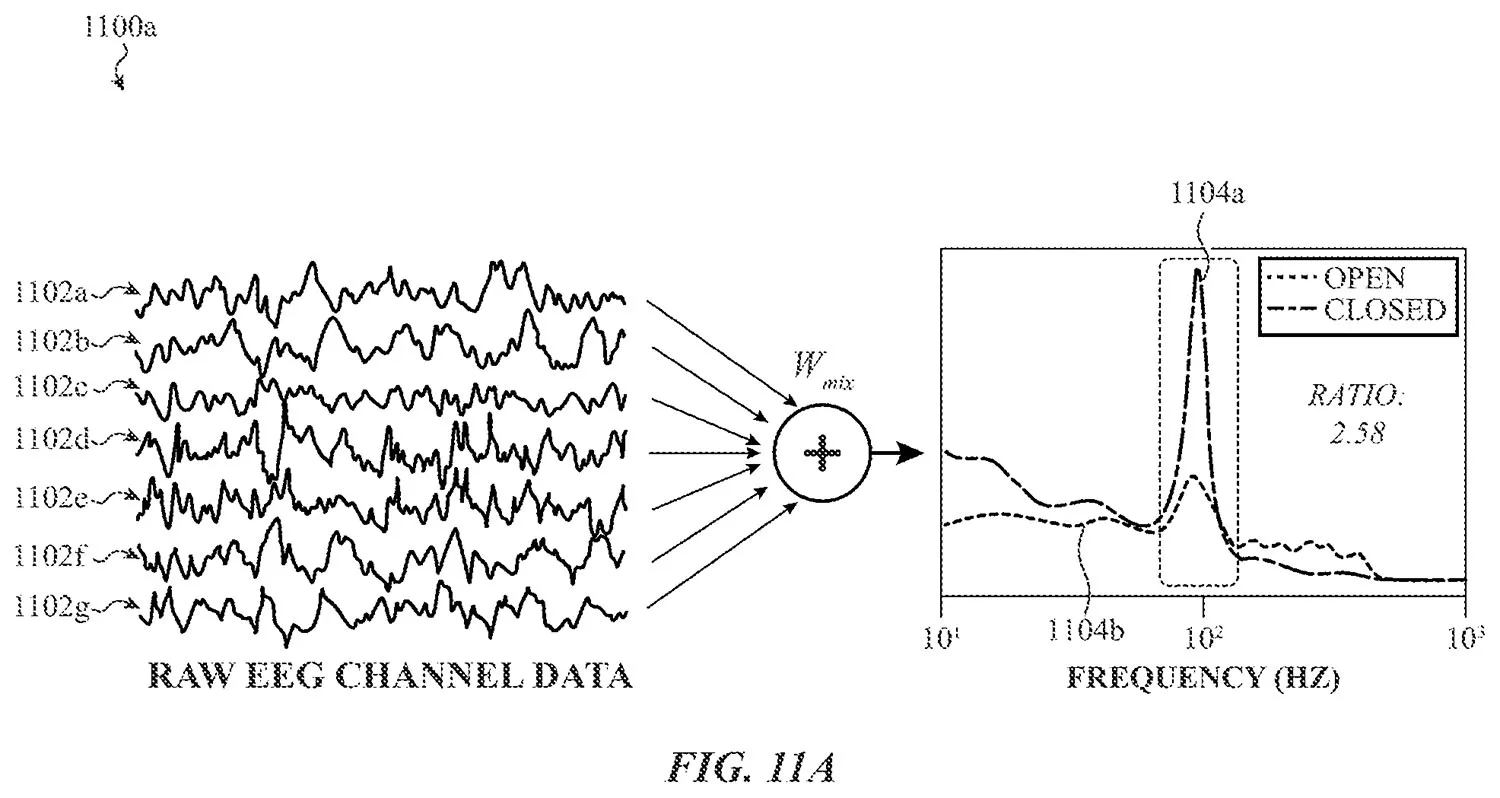

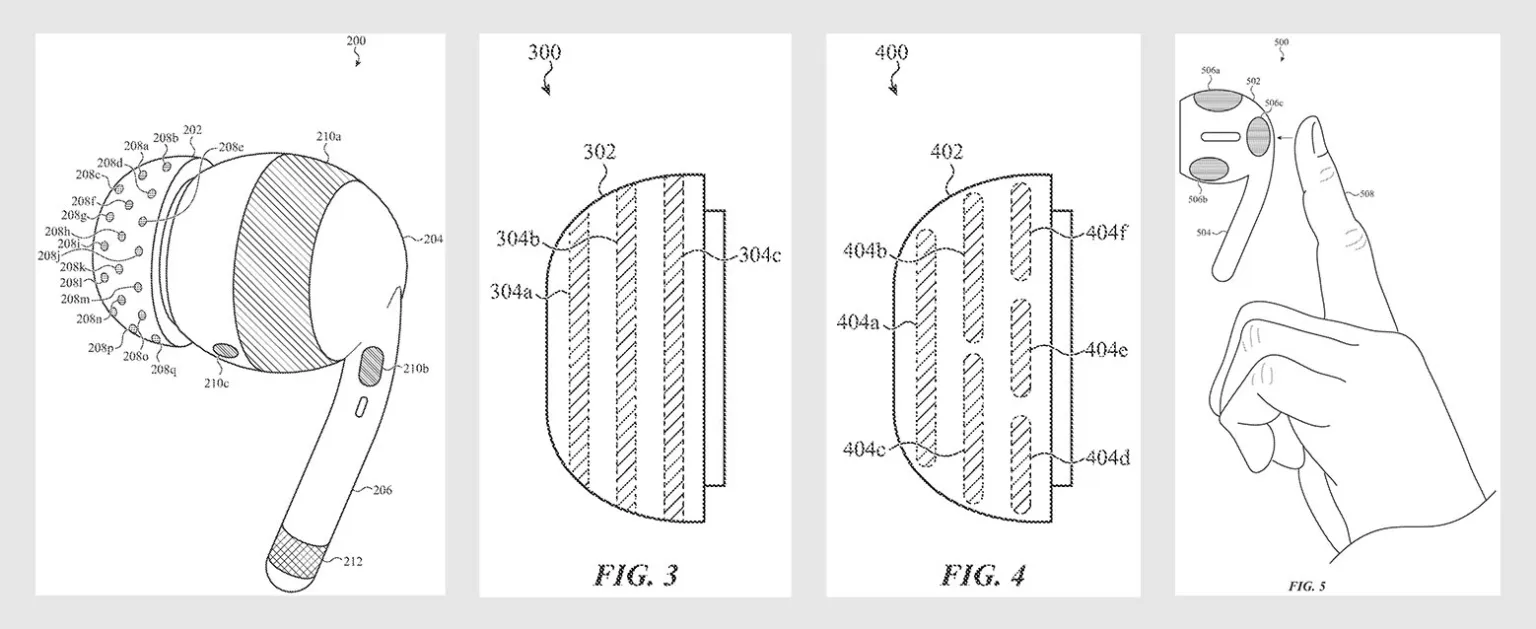

Nel 2023 Apple ha depositato un brevetto intitolato “wearable electronic device for measuring biosignals of a user”. Qui, la società parla esplicitamente di sistemi ear-EEG e delle difficoltà legate alla forma unica dell’orecchio di ogni persona. Per risolvere il problema, il brevetto propone di mettere più elettrodi del necessario negli auricolari e lasciare che l’AI scelga automaticamente quali funzionano meglio, in base a impedenza, livello di rumore, qualità del contatto con la pelle e distanza tra elettrodi attivi e di riferimento.

Una volta selezionati i canali migliori, l’AI peserebbe i vari segnali per costruire un’unica forma d’onda ottimizzata. Il brevetto descrive persino un gesto di tap o pressione sull’AirPod per avviare o interrompere la raccolta dati.

Non sorprende quindi che i casi d’uso elencati siano molto simili agli obiettivi del nuovo studio: monitoraggio del sonno e rilevazione di anomalie, come potenziali crisi epilettiche.

Cosa significa tutto questo per gli AirPods

È importante sottolineare che lo studio non menziona gli AirPods e non ha un legame diretto con il brevetto del 2023. Qui stiamo osservando due ricerche separate. Da un lato, Apple sta studiando come raccogliere segnali EEG dall’orecchio e, dall’altro, come interpretare questi segnali utilizzando modelli self-supervised.

Il punto è che entrambe le linee di ricerca puntano nella stessa direzione. Ciò ci fa pensare che Apple stia almeno prendendo in considerazione l’idea di creare un ecosistema auricolare in grado di fungere da vero e proprio sensore di salute neurologica.

- Filtra:

- Tutte

- Apple

- Minimo Storico

- Alimentari e cura della casa

- Auto e moto

- Bellezza

- Cancelleria e prodotti per ufficio

- Casa e cucina

- Elettronica

- Fai da te

- Giardino e giardinaggio

- Giochi e giocattoli

- Grandi elettrodomestici

- Illuminazione

- Informatica

- Moda

- Prima infanzia

- Prodotti per animali domestici

- Salute e cura della persona

- Sport e tempo libero

- Strumenti musicali

- Videogiochi

Leggi o Aggiungi Commenti