La versione di Apple Intelligence destinata al mercato cinese dovrà superare uno dei controlli più severi mai applicati a un sistema di intelligenza artificiale commerciale. Prima del lancio, il servizio verrà sottoposto a un test governativo composto da 2.000 domande progettate appositamente per far emergere contenuti vietati, politicamente sensibili o in contrasto con la narrativa ufficiale dello Stato.

Per essere approvata, l’IA dovrà rifiutarsi di rispondere ad almeno il 95% di questi prompt.

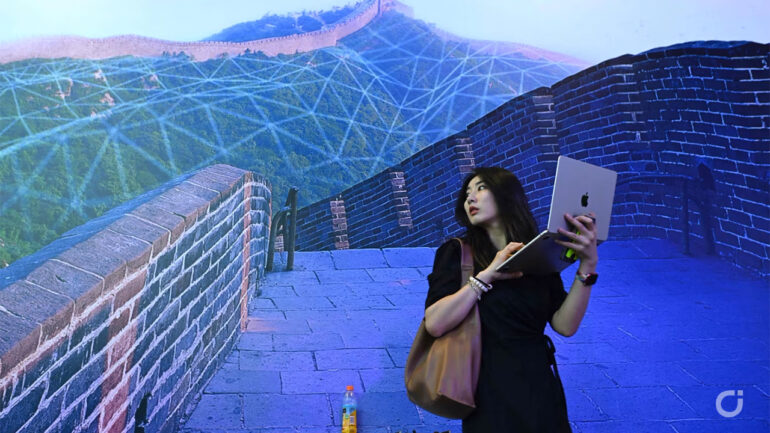

La notizia arriva dal Wall Street Journal e offre uno sguardo piuttosto chiaro su come Pechino intenda controllare anche la nuova generazione di strumenti basati sull’intelligenza artificiale. In Cina, il controllo dell’informazione online è da anni estremamente rigido. Molti servizi occidentali, come Google, Facebook, X e Wikipedia, sono bloccati dal cosiddetto Great Firewall, mentre anche i motori di ricerca locali devono rispettare filtri molto stringenti su termini e argomenti considerati sensibili.

Con l’arrivo dei chatbot e dei modelli linguistici avanzati, il problema si è semplicemente spostato. Un’AI è, di fatto, un motore di ricerca conversazionale, e proprio per questo motivo le autorità cinesi impongono che tutti i modelli operanti nel Paese rispettino regole severe. Le aziende straniere, Apple compresa, non possono utilizzare liberamente modelli occidentali e sono costrette a collaborare con partner locali approvati dal governo.

Nel caso di Apple Intelligence, questo significa dire addio a OpenAI e ChatGPT per il mercato cinese. Mentre nel resto del mondo Apple utilizza ChatGPT come fallback per Siri e, secondo indiscrezioni, anche modelli personalizzati di Google Gemini sui propri server, in Cina l’azienda ha dovuto stringere un accordo con Alibaba. Il modello scelto è Qwen3, il chatbot di Alibaba, ottimizzato per funzionare all’interno dell’ecosistema Apple.

Prima di essere reso disponibile al pubblico, però, Qwen3 integrato in Apple Intelligence dovrà superare un esame molto preciso. I regolamenti cinesi prevedono che i chatbot vengano testati con migliaia di domande su temi legati alla sicurezza nazionale, alla stabilità sociale, alla discriminazione e alla cosiddetta “sovversione del potere dello Stato”. Il sistema deve dimostrare di saper rifiutare in modo coerente e affidabile la stragrande maggioranza di queste richieste.

Il processo è talmente complesso che, secondo il Wall Street Journal, in Cina è nata una vera e propria industria specializzata nell’aiutare le aziende a “preparare” i propri modelli a superare questi test, in modo non troppo diverso da come ci si prepara a un esame standardizzato. Le domande vengono aggiornate almeno una volta al mese, rendendo il controllo continuo e non limitato alla fase di lancio.

Il paradosso, però, è evidente. Da un lato il governo cinese limita l’accesso a molte fonti informative esterne, impedendo ai modelli di addestrarsi liberamente sul web globale. Dall’altro, vuole che le IA sviluppate nel Paese siano competitive e potenti quanto quelle occidentali, che invece possono attingere a una quantità di dati molto più ampia. Il compito di filtrare, censurare e reinterpretare queste informazioni ricade quindi interamente sulle aziende tecnologiche.

- Filtra:

- Tutte

- Apple

- Minimo Storico

- Alimentari e cura della casa

- Auto e moto

- Bellezza

- Cancelleria e prodotti per ufficio

- Casa e cucina

- Elettronica

- Fai da te

- Giardino e giardinaggio

- Giochi e giocattoli

- Grandi elettrodomestici

- Illuminazione

- Informatica

- Moda

- Prima infanzia

- Prodotti per animali domestici

- Salute e cura della persona

- Sport e tempo libero

- Strumenti musicali

- Videogiochi

Leggi o Aggiungi Commenti