Apple ha acquisito Q.ai in un’operazione dal valore stimato di circa 2 miliardi di dollari. Anche se molti dettagli restano ancora poco chiari, alcuni aspetti del lavoro svolto dall’azienda rendono questa acquisizione particolarmente interessante per il futuro dell’intelligenza artificiale di Apple e di Siri.

Apple acquisisce regolarmente piccole aziende tecnologiche, ma raramente conclude operazioni di questa portata. Con un prezzo stimato di 2 miliardi di dollari, Q.ai diventa infatti la seconda acquisizione più costosa nella storia dell’azienda, superata solo dall’acquisto di Beats per 3 miliardi di dollari avvenuto oltre dieci anni fa.

Nonostante la cifra importante, il lavoro di Q.ai rimane in parte avvolto nel mistero. L’azienda ha sviluppato “tecnologie di machine learning per l’audio e per l’input vocale ‘silenzioso'”. Il sito ufficiale dell’azienda riassume la propria missione con lo slogan: “In un mondo pieno di rumore, creiamo un nuovo tipo di silenzio”.

Il sito tecnologico israeliano Geektime ha analizzato alcuni brevetti depositati da Q.ai, facendo emergere dettagli interessanti sul tipo di tecnologia sviluppata:

«Secondo le domande di brevetto, l’azienda sembra lavorare sulla lettura di ciò che viene detto non tramite la voce, ma utilizzando sensori ottici che rilevano i movimenti dei muscoli e della pelle del volto per tradurli in parole o comandi. Alcuni brevetti indicano l’uso di un visore che analizza anche guancia e mascella e che permetterebbe di parlare con Siri, l’assistente vocale di Apple, utilizzando esclusivamente i movimenti delle labbra.»

Secondo le prime indiscrezioni, questa tecnologia sarebbe pensata per essere integrata in dispositivi come occhiali smart e auricolari, inclusi gli AirPods.

Ed è proprio qui che l’acquisizione di Q.ai potrebbe risolvere uno dei maggiori problemi legati all’uso quotidiano dell’intelligenza artificiale. Negli ultimi anni, l’utilizzo di chatbot basati su modelli linguistici è cresciuto enormemente. Per molte persone, consultare strumenti come ChatGPT o Google Gemini è diventata un’abitudine quotidiana.

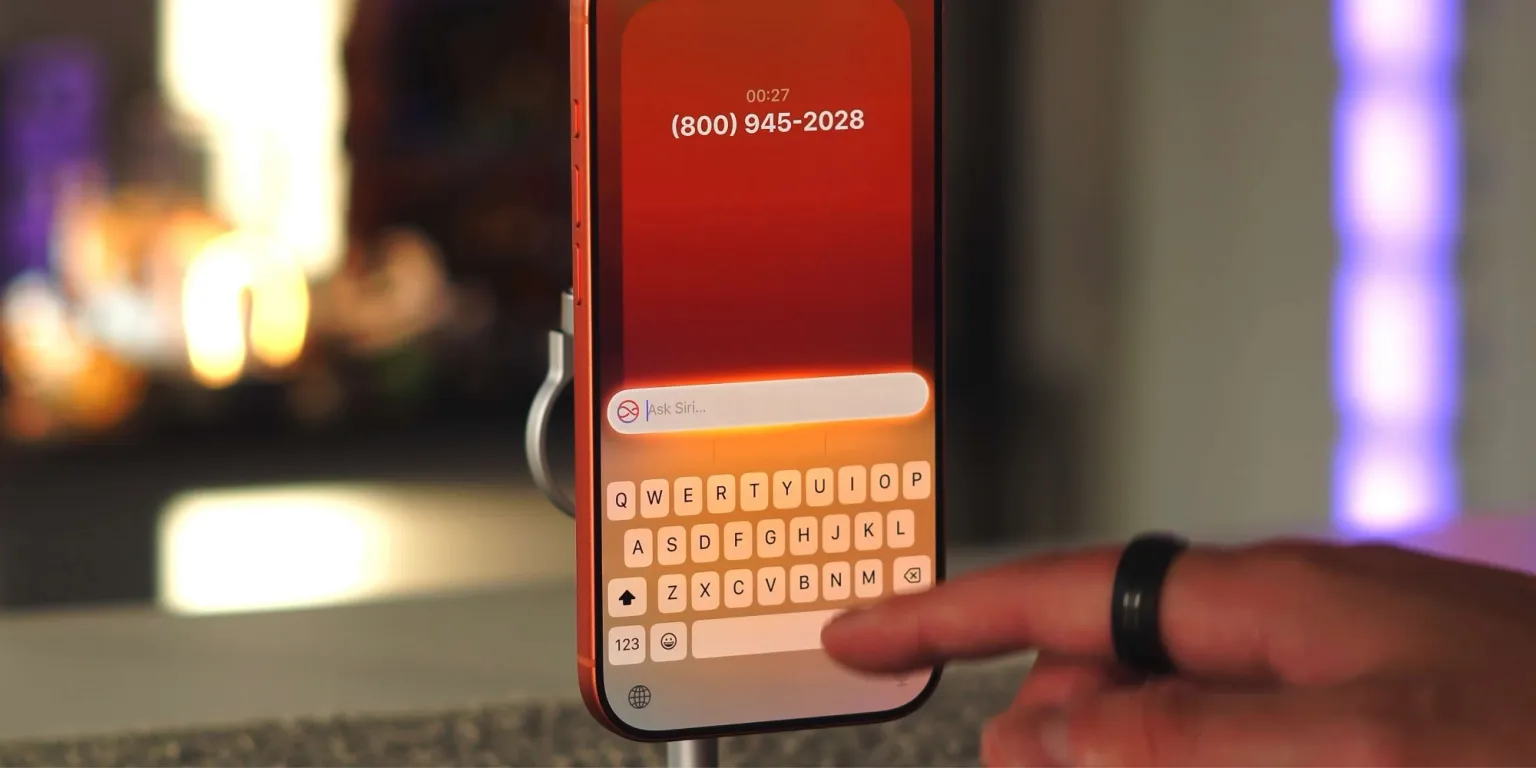

Nonostante i limiti di queste tecnologie, che talvolta possono fornire informazioni imprecise, il loro valore come risparmio di tempo è indiscutibile. Tuttavia, nella maggior parte dei casi, l’interazione avviene tramite tastiera e non con la voce. Il motivo è semplice: spesso ci si trova in ambienti condivisi, in casa con altre persone o in luoghi pubblici come bar e spazi di coworking.

Digitare richieste sull’iPhone può risultare scomodo e rallentare l’esperienza. Parlare ad alta voce, invece, crea un evidente disagio sociale. Se però una futura versione di Siri fosse in grado di comprendere movimenti facciali o sussurri quasi impercettibili, lo scenario cambierebbe radicalmente.

In quel caso, sarebbe possibile interagire con Siri in modo quasi silenzioso, senza estrarre l’iPhone dalla tasca e senza attirare l’attenzione. Un assistente sempre disponibile, utilizzabile ovunque, senza interrompere il contesto sociale.

Resta da capire come questa tecnologia verrà implementata concretamente. È probabile che entrino in gioco AirPods dotati di nuovi sensori e, in prospettiva, gli attesi Apple Glasses.

Leggi o Aggiungi Commenti