Nel futuro dell’intelligenza artificiale, Apple non vuole solo progettare dispositivi per gli esseri umani, ma anche per le intelligenze artificiali che ci imiteranno.

In un nuovo studio dal titolo “Humanoid Policy ~ Human Policy”, un team di ricercatori di Apple – in collaborazione con il MIT, la Carnegie Mellon University, l’Università del Washington e l’Università della California a San Diego – ha mostrato come il Vision Pro possa essere utilizzato per insegnare ai robot umanoidi a comportarsi come esseri umani. In senso letterale.

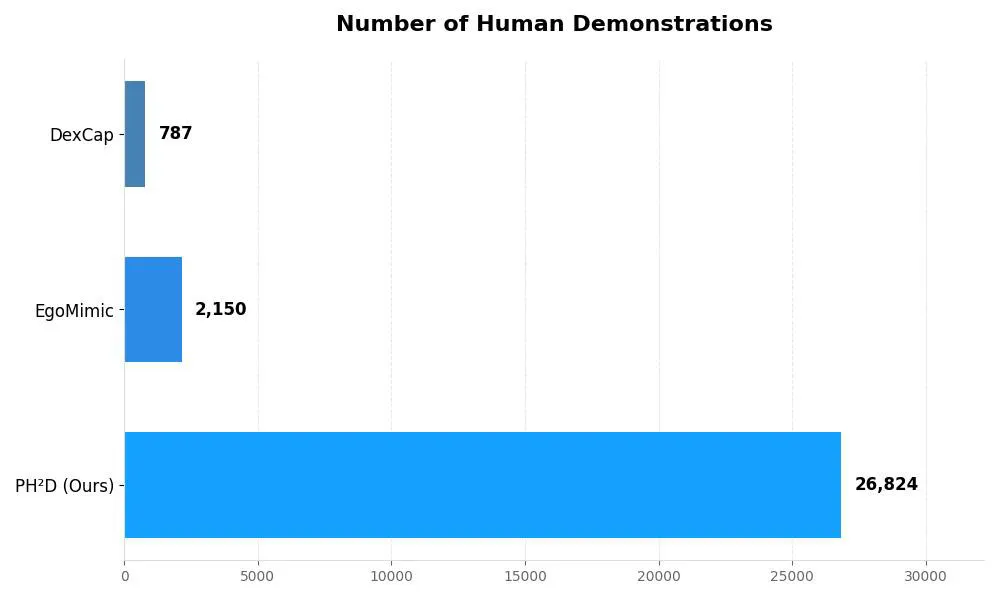

L’idea alla base di questo studio è tanto semplice quanto potente: mostrare ai robot il mondo dal nostro punto di vista. Per farlo, Apple ha sviluppato un’app dedicata per il Vision Pro che cattura video in prima persona usando la fotocamera posizionata in basso a sinistra del visore. Grazie all’integrazione con ARKit, l’app traccia il movimento tridimensionale della testa e delle mani, generando una grande quantità di dati realistici. Si tratta di oltre 25.000 dimostrazioni umane e 1.500 robotiche, racchiuse in un dataset chiamato PH2D.

Come insegnare a un robot a fare quello che facciamo noi?

Fino a oggi, addestrare i robot a manipolare gli oggetti è sempre stato un processo costoso, lungo e difficile da scalare. Era necessario avvalersi di operatori umani con competenze specifiche, hardware dedicato e ore di lavoro. Con questo nuovo approccio, invece, bastano pochi secondi e un visore per raccogliere dati utili a insegnare a un robot a eseguire (quasi) le stesse azioni.

Per rendere il sistema ancora più accessibile, i ricercatori hanno anche creato un supporto stampato in 3D per agganciare una videocamera ZED Mini ai visori più economici come Meta Quest 3, offrendo un’alternativa meno costosa ma comunque efficace per il tracciamento del movimento.

Un’altra genialata? Durante l’addestramento, le dimostrazioni umane sono state rallentate di quattro volte, in modo da permettere ai robot, notoriamente più lenti, di comprendere e replicare i movimenti senza la necessità di adattamenti complessi.

Un solo cervello, due corpi

Il cuore dello studio è un modello chiamato HAT, in grado di imparare da dati sia umani che robotici in un formato unificato. Non c’è alcuna distinzione tra “quello che fa un umano” e “quello che fa un robot”: HAT impara una politica condivisa che funziona su entrambi i fronti, rendendo l’intero sistema più adattabile, efficiente e potente.

Nei test, questo approccio ha permesso ai robot di affrontare compiti più complessi, inclusi quelli mai visti prima durante l’addestramento. Il tutto con maggiore successo rispetto ai metodi classici che si basano solo su dimostrazioni robotiche.

Fantascienza o futuro prossimo?

Apple non sta (ancora) costruendo un robot domestico con il suo logo. Tuttavia, è evidente che l’azienda sta guardando oltre i suoi dispositivi attuali, immaginando un futuro in cui l’intelligenza artificiale si integra con la robotica in modo molto più concreto. In cui un visore per la realtà aumentata può diventare lo strumento per formare l’intelligenza motoria del nostro futuro compagno automatizzato.

L’idea di avere un robot umanoide in casa ti spaventa? O pensi che sia il passo successivo più naturale nell’evoluzione tecnologica? Diccelo nei commenti.

Leggi o Aggiungi Commenti